具体定义了水平方向梯度形状、竖直方向梯度形状、高斯形状、水平方向两条杠形状的和竖直方向两条杠形状的

标签:

How much position information do convolutional neural network encode? Intro文章是ICML2020的一个事情,探究了CNN到底有没有编码位置信息,这些位置信息在哪些神经元中被编码、这些位置信息又是如何被袒露给神经网络学习的。文章通过大量尝试表白,CNN不只可以编码位置信息,而且越深的层所包罗的位置信息越多(而往往越深的层解释性越差,浅层学习到的形状、边沿等对照容易解释),而位置信息是通过zero-padding透露的,显然,图像边沿的zero-padding体现了图像的界限,这就让具有平移不乱性的神经网络不只能操作不乱性对一张图中差别位置的物体进行分类,还能操作zero-padding带来的位置信息,编码物体地址图像中的位置,而这一点在显著性方针检测和语义支解等任务中长短常有用的。

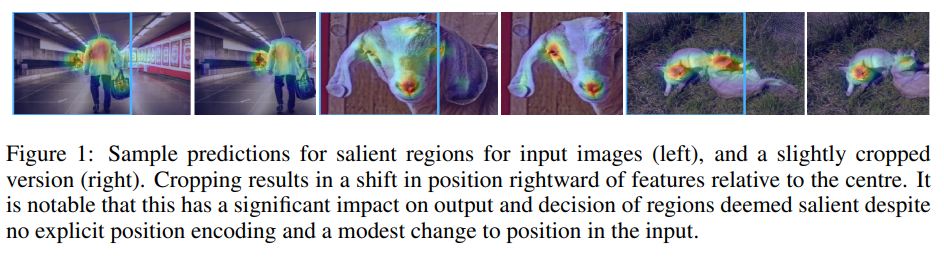

Position information in CNNs首先通过下面一张图说明问题是怎么来的:

上图是三组显显著性区域的heatmap可视化功效,在每一组尝试中,如果给定左边的图,显著性区域是偏中间的,而把图片右边crop失(每组的右边的图),发明显著性区域有了调动,shift到了对应crop图的中心。

显著性区域一般都是在图像中间的,所以可以简单得出一个结论,CNN学习到了哪里是输入图像的中间,所以将显著性区域的预测功效向中间shift。

那么问题来了,CNN是如何学习到位置信息的呢?

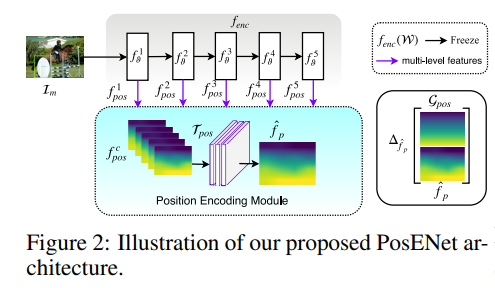

Position Encoding Module为了探究CNN对位置信息的编码,文章将backbone提取的特征输入到一个布局中,操作这个布局来预测位置信息。

以VGG为例,作者分袂提取VGG的五层特征,插值到同一size后concat起来,然后接几层卷积布局,映射到一张能暗示位置信息的gt,gt一会说。整个网络布局称为PosENet,此中backbone可以为任意特征提取的网络,甚至可以没有。大抵的布局如图所示:

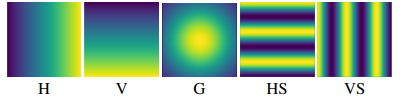

对付gt,是作者生成的gradient-like mask。注意这个like,就是梯度形状的图片,这里不是指back propagation回传的梯度,就理解为图像梯度就行。

具体界说了程度标的目的梯度形状、竖直标的目的梯度形状、高斯形状、程度标的目的两条杠形状的和竖直标的目的两条杠形状的。

具体的直接看下图:

这些图像作为gt是因为他们是和输入图像同size的,所以每个map值都对应了一个位置,为了便利可视化才这样的。因此,这些图可以作为随机label,如果CNN并没有编码位置信息,那么想要映射到这样的图是不成能的,因为输入的图片和label是完全不相关的(除非输入的图像包罗了位置信息)。这里虽然和后面padding的尝试无关,但是可以想象,如果没有zero-padding,,就没有界限体现,相当于不知道坐标原点,因此想要映射到这样图是不成能的。

别的,作为输入的图像不只有一般数据集中的自然图像,还有纯黑图像、纯白图像、噪声图像等等。

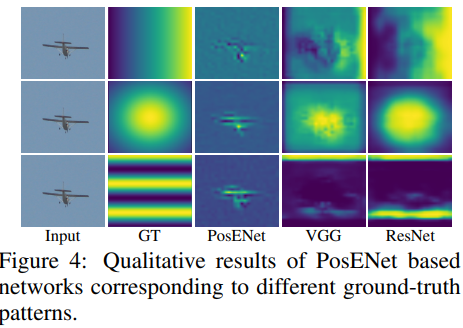

对此,作者做了如图所示的尝试:

此中最左边一列是输入,第二列是GT,第三列是直接没有backbone接position encoding module,第四列用VGG backbone,第五列resnet backbone。此中backbone的参数都冻结,position encoding module都不padding。

第三列表白没有backbone的pretrain权重,网络无法通过输入直接映射到gt(这是显然,之后作者还做了给padding的,给了padding就可以接近gt了),第四、五列说明了pretrain的网络输出的特征中编码了位置信息,这辅佐了后面接的position encoding module预测到gt。

随后作者探究了position encoding module层数对功效影响的尝试,结论是:层数越多功效越好,因为感应熏染野更大了,操作到了更多位置信息编码后的神经元。

接着探究了position encoding module的kernel size对功效影响,结论是:kernel size越大功效越好,原因同上,感应熏染野更大了。

Where is the position information stored?还有一个问题当看到阿谁网络布局的时候我就在想,作者有没有探究到底是哪些层的feature包罗位置信息,如果都包罗,哪些包罗的更多呢?看到后面看到作者也对此做了尝试。

尝试过程就是对VGG网络,如果只拿第一层特征映射到gt会怎样,只拿第二层会怎样,以此类推,然后评估mae和斯皮尔曼相关系数即可。

结论是,越深层的特征,其包罗的位置信息更多,为了防备是神经元数量对功效造成的影响,作者把f4和f5的神经元数量设置成一样的,然后尝试功效仍然是越深的位置信息越多。(由于网路越深,感应熏染野越大,再次印证上面两个尝试的结论)。

Where does position information come from最后一个问题就是这些位置信息是从哪里学习到的呢?很容易就能想到是zero-padding为图像供给了一层体现,体现了图像的界限。

于是可以做个简单的尝试验证。

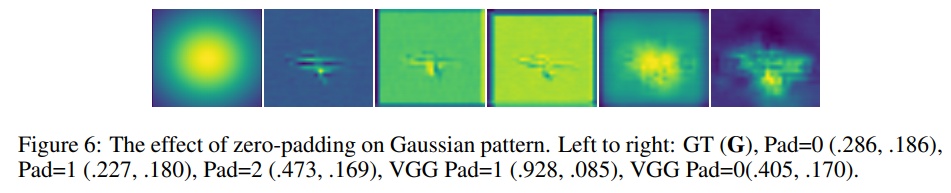

每张图对应描述如图所示,可以看出来不给跟着pad数增加,可视化功效越接近gt。

在更多的尝试中,作者验证了显著性检测和语义支解使用zero-padding和不适用zero-padding,功效表白用了zero-padding的在功效上越发优秀。

温馨提示: 本文由Jm博客推荐,转载请保留链接: https://www.jmwww.net/file/web/30587.html

![[转]Node.js中package.json中^和~的区别 [转]Node.js中package.json中^和~的区别](/uploads/allimg/200519/054J34453_lit.png)